CVPR2022高被引论文笔记

一、目标检测

1.1 视频目标检测

Video Swin Transformer

标题:视频 Swin Transformer

作者团队:Microsoft Research Asia

期刊会议:CVPR

时间:2022

代码:https://github.com/CompVis/latent-diffusion

(1)目标问题

现今大多数的视觉识别模型都是基于Transformer建立的,本文在此基础上进行调整,得到更好的速度和精度。

(2)方法

- 总体架构

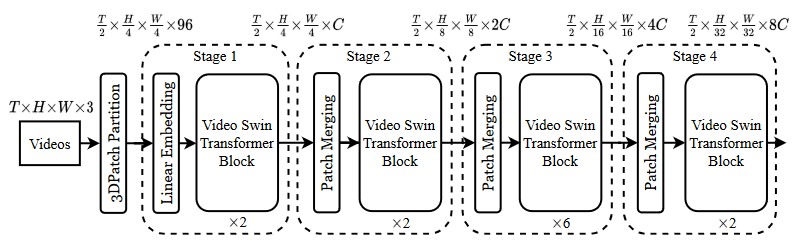

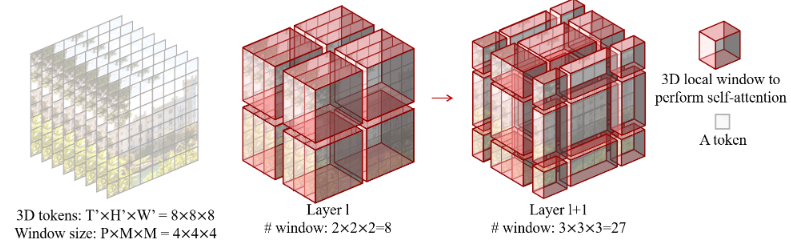

视频定义为TxHxWx3,patch为2x4x4x3的块,每个patch有96个特征维度。该架构的主要组件是Video Swin Transformer模块,通过将标准的Transformer的Multihead self-attention(MSA)模块替换为基于3D Shift Window的MSA模块,来实现。

- 3D MSA模块

由于视频有时间维度,全局自注意模块会导致巨大的计算和内存成本。MSA模块就比传统的全局自注意模块要高效。

更进一步,基于Swin Transformer的2D移位窗口扩展到3D,实现了跨窗口链接,保证了体系结构的表达能力。

二、图像分割

三、图像处理

3.1 图像合成

High-Resolution Image Synthesis with Latent Diffusion Models

标题:具有潜在扩散模型的高分辨率图像合成

作者团队:海德堡大学;Runway ML

期刊会议:CVPR

时间:2022

代码:https://github.com/CompVis/latent-diffusion

(1)目标问题

扩散模型已经在包括图像数据在内的很多数据上,实现了很好的数据合成效果。但这些模型由于直接操作像素,需要昂贵的GPU资源。

本文提出的潜在扩散模型,达到了降低复杂性和保留细节的平衡点。

(2)方法

主要方法是:使用自动编码模型,学习一个在感知上与图像空间等效的空间,压缩学习阶段和生成学习阶段来减少资源需求。

- 感知压缩模型

利用了结合perceptual loss, patch-based, adversarial objective的自动编码器。 - 潜在扩散模型

扩散模型是概率模型,通过逐渐对正态分布变量去噪来学习数据分布。

通过由自动编码器得到的高效、低维的空间,与高维像素空间相比更适合生成模型。 - 调节机制

通过使用交叉注意力机制增强基础网络UNet,能够处理各种模态的输入。

(3)思考

将需要高运算量的像素操作,通过自动编码转换为了低维空间的操作,节省了计算量。

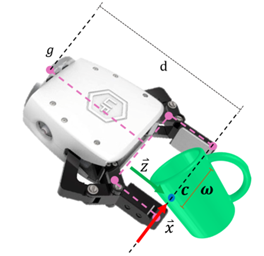

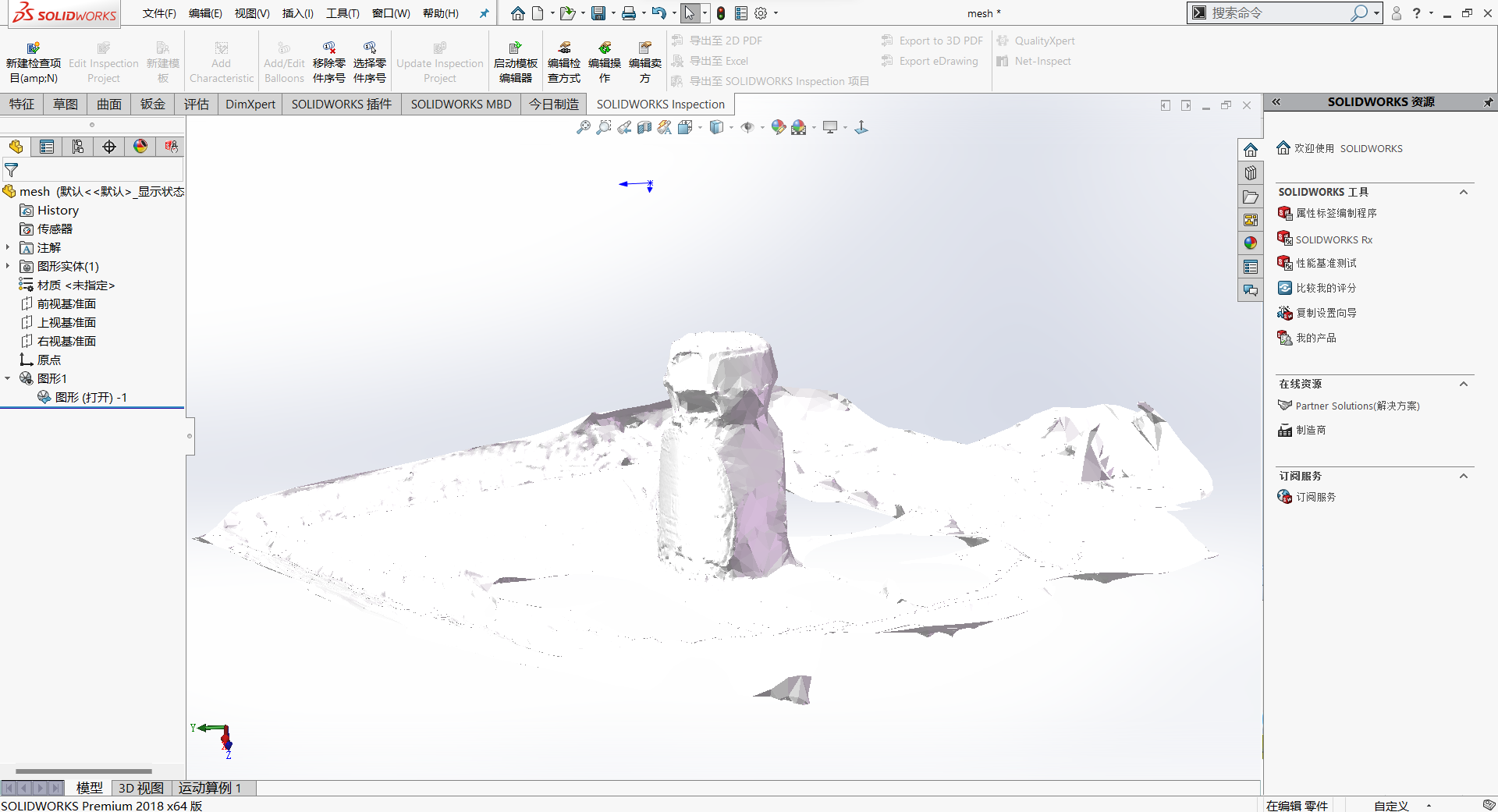

四、三维视觉

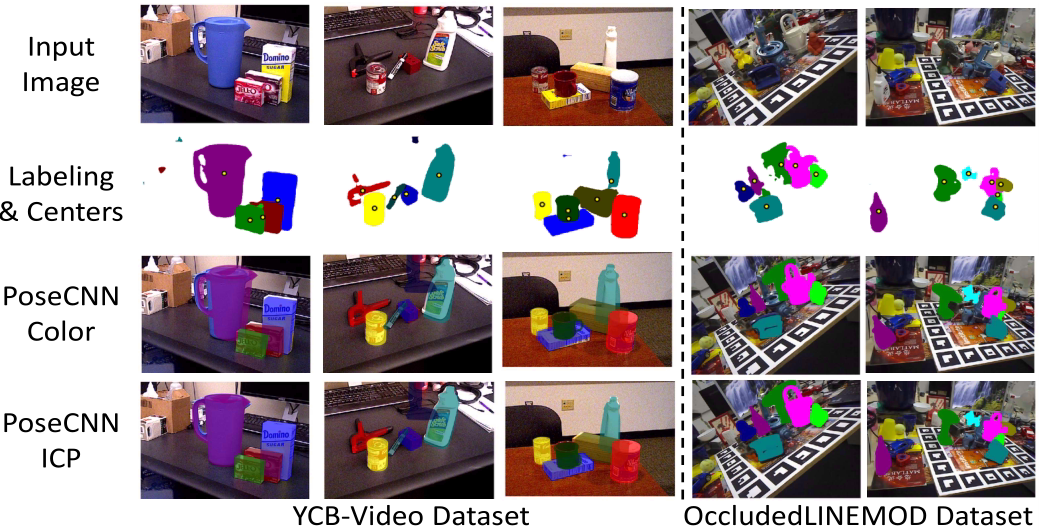

五、位姿估计

六、机器人

七、神经网络

7.1 神经网络结构设计

A ConvNet for the 2020s

标题:2020s的ConvNet

作者团队:Facebook AI

期刊会议:CVPR

时间:2022

代码:https://github.com/facebookresearch/ConvNeXt

(1)目标问题

20年以来,由于Vision Transformers的引入,它开始快速取代卷积神经网络。但只使用Transformers也有些问题,因此后来又出现了hierarchical Transformers,其中加入了几个卷积神经网络作为先验。但这些方法都可以归结为Transformers的优势。

本文想要探讨纯卷积神经网络所能实现的极限。

(2)最佳方法

- 训练技术:使用AdamW优化器、数据增强、随机擦除、正则化等方法可以显著提高训练模型的性能

- 宏观设计:

- 阶段比例:ResNet中各阶段的比例很大程度是经验获得的,SwinTransformer的比例是1:1:3:1,传统的ResNet比例是(3,4,6,3),此处调整为(3,3,9,3)与SwinT相同,发现也提高了模型准确率

- 模块设计:标准的ResNet模块包括一个7x7步长2的卷积层,然后是一个最大池化层。此处模仿SwinT,设计为4x4步长为4的卷积层作为基础模块。

- 使用分组卷积技术,可以有效提高网络性能

- 反向瓶颈:使MLP的隐藏维度比输入维度宽4倍,这在几个ConvNet中以及Transformer中设计思路相同。

- 更大的卷积核:尽管堆叠小卷积核可以有效利用硬件,但测试证明,总体上大卷积核能够提高模型性能

- 微观设计:

- 更少的归一化层

- 使用层归一化LN代替批归一化BatchNorm

- 分离下采样层:ResNet中,下采样是通过每个阶段开始的残差块实现的,在层和层之间加入单独的下采样层发现可以提高准确率

(3)总结

- 尽可能丰富数据,增大随机化程度:使用AdamW优化器、数据增强、随机擦除、正则化等方法

- 使用更优化的网络结构:调整各阶段卷积比例、使用反向瓶颈设计、更少的归一化层、更大的卷积核、在每个阶段之间加入下采样层。