【课程笔记】Stanford CS25 V2 - Robotics and Imitation Learning

Video Link: https://www.youtube.com/watch?v=ct4tdyyNDY4

过去两年,由于大语言模型、语音技术、视觉技术的发展,机器人技术的研究思路发生了180度的转变。

机器人基础模型

目前在大量数据上进行大规模模型训练时,通常由两个比较重要的属性:

- 涌现:当非常简单地事情在小范围发挥作用时,当扩大范围,它的表现会更好,例如更多的数据、更大的模型。

- 均质化:模型可以组合许多下游任务来实现泛化能力

当然我们可能会思考一个问题,为什么目前还没有机器人领域的基础模型。不像音频、语言、图像等领域,这些领域已经出现了较为通用的基础模型,机器人技术的基础模型还没有人研究出来。

那么如果想要实现机器人的基础模型,可以如何做:

(1)设计强化学习算法

- 利用高性能的架构,例如self-attention

- 利用比例法则,不仅要扩大模型大小,还有扩展计算,还需要扩大数据集语料库以及标记数量

- 数据集大小比数据质量更重要

(2)互联网规模的模型扩散

- 生成式模型在语言、编程、视觉、音频等领域已经展现出了涌现的能力,并且一次次超出了我们的预期,这个趋势在可见的未来中还会一直保持下去。

- 涌现和加速意味着这些模型可以“自己”变的更好

(3)从在线机器人学习转移到离线学习

- 目前的大模型都是在巨大规模的离线数据集上训练完成的

Google Brain 相关工作

过去工作

(1)2016 - 机器人工厂

- 强化学习:Google建立了一个包含7个Kuka机械臂的机器人工厂,7x24小时执行抓取动作,进行强化学习训练。

- Qt-Opt:Q-学习算法,接受视觉输入的同时进行连续控制。

- RL-CycleGan:将房展环境的图像转换为真实的图像,让机器人在显示世界中更好地完成任务。

(2)2020 - 厨房环境

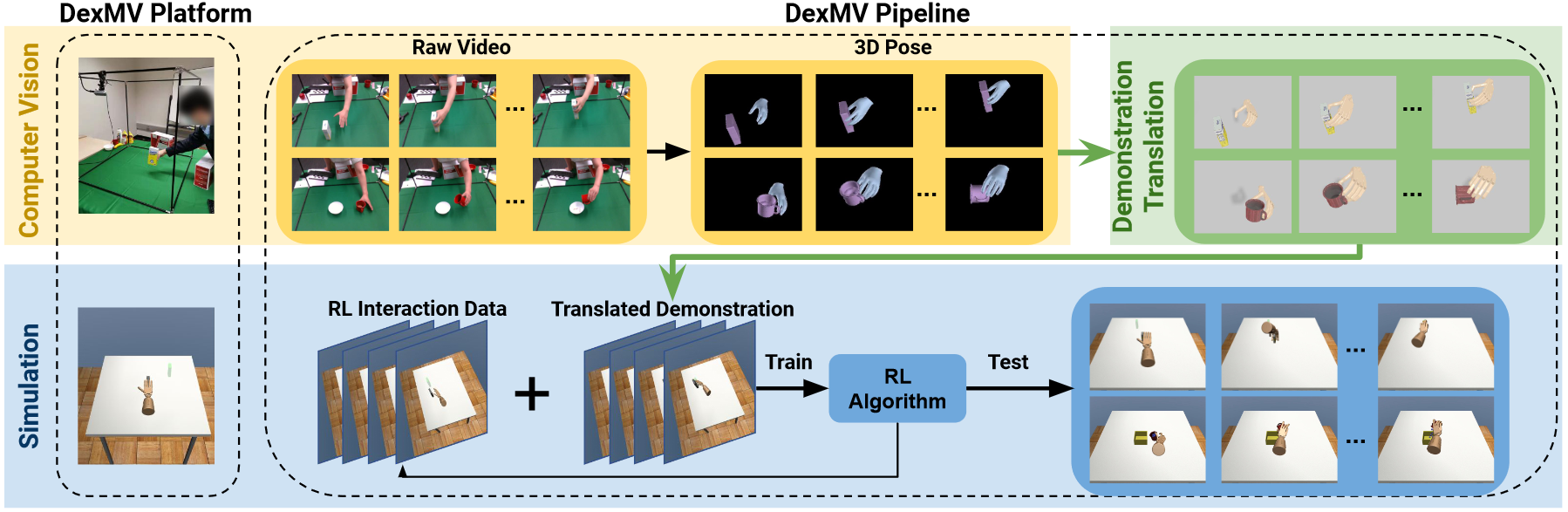

- BC-Z:多任务模仿学习

- AW-Opt:将强化学习与模仿学习引导相结合

(3)2022

遇到了一些问题,例如在一些场景任务中,成功率已经稳定到了50~70%,一些方法需要非常特定的数据分布,如果策略没有训练过当前的数据,那么任务很可能失败。为了解决这个问题,Google 进行了以下工作

- 多任务模仿学习

- 使用大规模数据集

近期工作

(1)RT-1

主要聚焦于如何扩展模仿学习。

- 使用一年半时间从13个机器人中收集了100k的演示数据,包括700个任务

- 使用BC-Z进行训练

- 由于基于Transformer的算法在处理图像时,现在还不足以支撑机器人学习中的高频率、实时性要求,因此希望数据集能够理解语言模型。

从较高的层面来看,RT-1是一个机器人Transformer,它接受机器人摄像头的视觉输入,以及自然语言指令,仅仅使用transformer进行解码,分离目标物体类别,使用预训练的EfficientNet主干网络得到离散化动作。

(2)SayCan

机器人的技能能够是有限的,大语言模型也是受限制的,他不知道机器人的状态,不知道周围环境。

因此这项工作主要实现让语言模型说机器人的语言。

(3)Inner-Monologue

将环境的动态环境反馈加入到闭环中,也使用语言的API来传达环境中有什么。

评论